Ventana de contexto de una IA

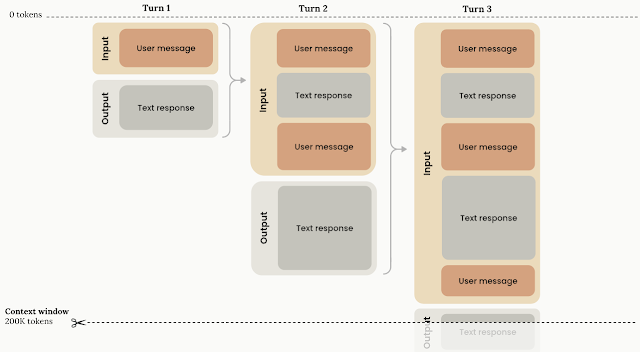

La ventana de contexto en inteligencia artificial, especialmente en modelos de lenguaje grandes (LLMs), se refiere a la cantidad de información que el modelo puede procesar y "recordar" al generar texto. Esta ventana se mide en tokens, que son unidades de texto como palabras, fragmentos de palabras o caracteres.

29 de junio de 2025

Introducción

En el vertiginoso mundo de la inteligencia artificial (IA), la capacidad de los modelos de lenguaje para procesar y generar texto coherente depende en gran medida de un concepto fundamental: la ventana de contexto. Este parámetro técnico determina la cantidad de información previa que un modelo puede considerar al generar una respuesta, influenciando directamente la calidad y relevancia de las interacciones.

¿Qué es una ventana de contexto?

La ventana de contexto, también conocida como longitud de contexto, se refiere al número máximo de tokens (unidades de texto que pueden ser palabras, partes de palabras o caracteres especiales) que un modelo de lenguaje puede procesar en un único ciclo de inferencia. Esta "memoria operativa" define cuánta información previa puede tener en cuenta al generar una respuesta. Por ejemplo, si un usuario pregunta a un chatbot sobre un tema discutido veinte mensajes atrás, la capacidad del modelo para recordar ese detalle depende directamente del tamaño de su ventana de contexto. (comunicagenia.com)

Importancia de la ventana de contexto

Una ventana de contexto amplia permite a los modelos mantener conversaciones fluidas sin perder el hilo del diálogo. Esto es particularmente relevante en aplicaciones como el asesoramiento médico virtual, donde recordar detalles mencionados al principio de la conversación puede ser vital. (comunicagenia.com)

Además, una ventana de contexto más grande ofrece numerosas ventajas:

Mayor coherencia conversacional: Al recordar más información previa, el modelo puede mantener el hilo de la conversación de manera más efectiva, generando respuestas que se sienten más naturales y relevantes.

Mejor comprensión de instrucciones complejas: Cuando se proporcionan instrucciones detalladas o que se extienden a lo largo de varios turnos, una ventana de contexto amplia permite al modelo mantener todas las partes de la instrucción en mente.

Capacidad para tareas más sofisticadas: Tareas como la generación de historias largas, la traducción de documentos extensos o la respuesta a preguntas basadas en un texto largo se benefician enormemente de una ventana de contexto generosa.

Personalización mejorada: Al recordar interacciones previas con un usuario específico, el modelo puede ofrecer respuestas más personalizadas y adaptadas a sus preferencias o historial. (mejoriadigital.com)

Tamaños de ventana de contexto en modelos de lenguaje

La capacidad de una IA para manejar contextos más amplios ha evolucionado significativamente en los últimos años. A continuación, se presentan algunos ejemplos de modelos de lenguaje y sus respectivas ventanas de contexto:

| Modelo | Ventana de contexto | Aplicaciones clave |

|---|---|---|

| GPT-4 Turbo (OpenAI) | 128.000 tokens | Análisis documental, generación de código, atención al cliente avanzada |

| Claude 3 Opus (Anthropic) | >200.000 tokens | Procesamiento de grandes volúmenes de texto legal, auditorías |

| Gemini 1.5 Pro (Google) | Hasta 1 millón de tokens | Casos de uso masivo en salud, seguros, logística |

| Llama 3 (Meta) | 8.000–32.000 tokens | IA embebida en sistemas internos, proyectos open source |

| Mistral (open source) | 8.000–16.000 tokens | Integraciones ligeras con control on-premise |

ventana de contexto con el generador de código con Pollinations (Vibe Coder)

- Una página web sobre mariposas, obteniendo:

- Incluye siete mariposas más. La IA recuerda la respuesta anterior y agrega las siete mariposas.

- Mejora la página permitiendo hacer clic sobre las imágenes para que se abran en una pestaña aparte, obteniendo

Desafíos asociados con ventanas de contexto grandes

Aunque las ventanas de contexto amplias ofrecen ventajas significativas, también presentan desafíos:

Elevado coste computacional: El procesamiento escala de forma cuadrática: duplicar la longitud de entrada requiere cuadruplicar los recursos. Esto encarece el uso de modelos, especialmente para empresas que pagan por token. (ibm.com)

Saturación de información: Estudios de Anthropic y Google han demostrado que los modelos tienden a priorizar la información ubicada al inicio y al final del contexto, ignorando a veces datos críticos en el medio. (comunicagenia.com)

Vulnerabilidades de seguridad: Ventanas más grandes amplían la superficie de ataque para técnicas de jailbreaking, donde un adversario podría ocultar instrucciones maliciosas en textos largos para eludir filtros. (comunicagenia.com)

Latencia en respuestas: Procesar millones de tokens puede ralentizar la generación de respuestas, lo que resulta problemático en aplicaciones en tiempo real como asistentes de voz. (ibm.com)

Técnicas para optimizar el uso de ventanas de contexto grandes

Para superar estos desafíos, los investigadores han desarrollado varias soluciones:

Atención eficiente: Métodos como Ring Attention dividen el texto en bloques procesados en paralelo, reduciendo la carga de memoria. (comunicagenia.com)

Codificación relativa de posiciones: En lugar de recordar la posición absoluta de cada token, el modelo calcula relaciones entre tokens cercanos. (comunicagenia.com)

Compresión de prompts: La generación de datos sintéticos permite resumir información clave antes de ingresarla al modelo, haciendo más eficiente el uso de la ventana de contexto. (comunicagenia.com)

Implicaciones para aplicaciones empresariales

La capacidad de manejar ventanas de contexto más grandes tiene implicaciones significativas en diversos sectores:

Atención al cliente: Un chatbot que no puede mantener el contexto de múltiples interacciones con el cliente ofrecerá una experiencia inconsistente. (revistacloud.com)

Legal y compliance: Un modelo con poca capacidad contextual puede “perder” cláusulas críticas al resumir o analizar contratos. (revistacloud.com)

Sanidad y seguros: Procesar historiales clínicos o pólizas requiere contexto amplio para evitar errores de interpretación. (revistacloud.com)

Análisis financiero: La generación de informes a partir de múltiples fuentes de datos exige un modelo capaz de leer y cruzar grandes volúmenes de información. (revistacloud.com)

Conclusión

La ventana de contexto es un componente esencial en el diseño y funcionamiento de los modelos de lenguaje de inteligencia artificial. Su capacidad para procesar y retener información previa determina la coherencia y relevancia de las respuestas generadas. A medida que la tecnología avanza, es probable que veamos modelos con ventanas de contexto aún más amplias, lo que permitirá interacciones más naturales y precisas. Sin embargo, es fundamental equilibrar el tamaño de la ventana de contexto con los recursos computacionales disponibles y las necesidades específicas de cada aplicación para garantizar un rendimiento óptimo.

Comentarios

Publicar un comentario

Haz tu comentario, que nos ayude a mejorar